Qu'est-ce que l'AI Act?

L’Artificial Intelligence Act (AI Act) est un règlement européen qui a notamment pour objectif de veiller à ce que les systèmes d’IA mis sur le marché de l’Union et utilisés soient sûrs et respectent la législation en vigueur en matière de droits fondamentaux.

Le règlement suit une approche fondée sur les risques et distingue les utilisations de l’IA qui créent un risque inacceptable, un risque élevé et un risque faible ou minimal sur la santé, la sécurité, les droits fondamentaux, l’environnement, la démocratie et l’État de droit. Il n’impose des charges réglementaires conséquentes qu'aux systèmes d’IA à haut risque. Ceux-ci sont listés dans une annexe et classés en fontion de leurs usages: gestion des infrastructures critiques, dispositifs médicaux, affectation des personnes aux universités, recrutement pour des emplois, la gestion des migrations et des frontières, la prise de décisions de justice,… Pour les systèmes d’IA acceptables qui ne sont pas à haut risque, seules des obligations de transparence très limitées sont imposées.

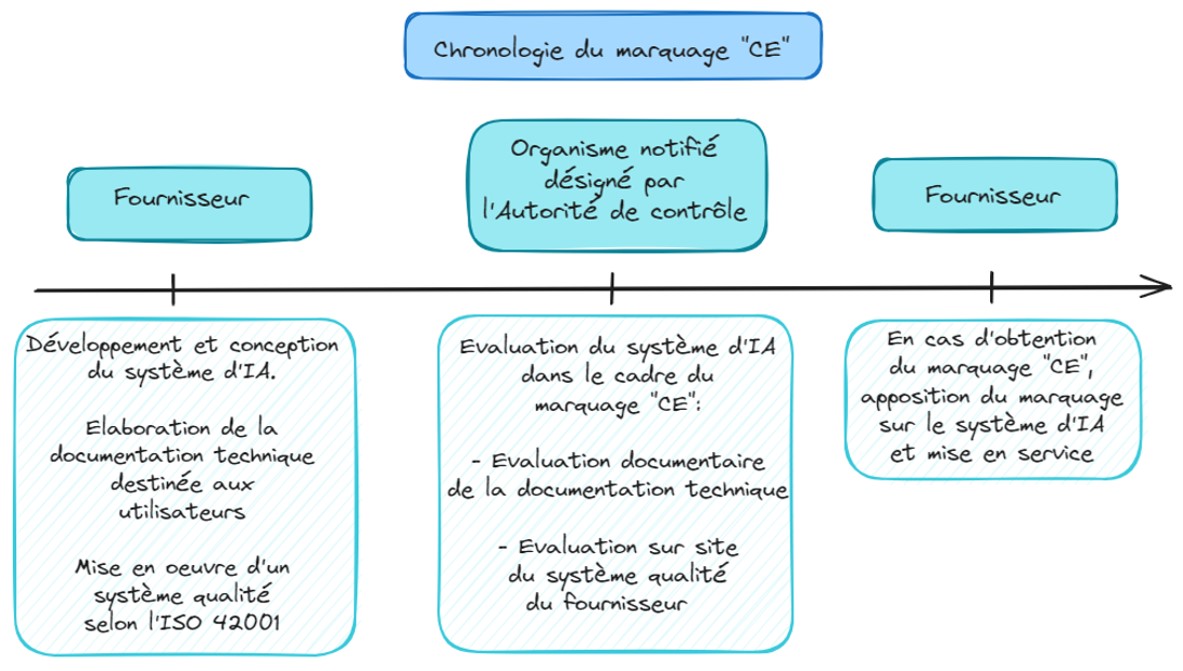

Les fournisseurs de système d’IA à haut risque devront obtenir un marquage CE sur leur système par un organisme notifié. La vérification de la conformité à l’AI Act par l’organisme notifié s’appuiera sur 2 types d’évaluations (ces 2 évaluations seront obligatoires dans certains cas, mais il sera peut-être possible également de s’auto-déclarer dans d’autres cas) :

- Une évaluation de la documentation technique du système d’IA (conception, fonctionnalités, description du système, ...)

- Une évaluation du système de management de la qualité de l’organisme.

Le règlement a été voté par le Parlement européen dans son ensemble le 13 mars 2024 en vue d’une publication ultérieure au Journal officiel de l’Union européenne. Il entrera en vigueur 20 jours après sa publication au Journal officiel et sera pleinement applicable 24 mois après son entrée en vigueur.

Qu'est-ce que l'ISO 42001?

La norme ISO 42001 spécifie les exigences pour la mise en œuvre d’un système de management de l’intelligence artificielle (SMIA) avec amélioration continue au sein d’un organisme. Elle est structurée avec un chapitrage identique à celui de la norme ISO 9001 (management de la qualité) et les autres normes de système de management (ISO 27001, ISO 27701, …).

Son élaboration a été concomitante à l’élaboration de l’AI Act et ce n’est pas un hasard. Elle est pressentie pour être la norme harmonisée recommandée aux fournisseurs de système d’IA à haut risque lorsqu’ils mettent en œuvre leur système qualité afin de répondre aux enjeux de l’AI Act dans le cadre de l’obtention d’un marquage « CE » pour leur produit.

De façon similaire à la norme ISO 27001, la norme ISO 42001 contient une annexe qui liste des mesures à considérer par les organismes qu’ils devront mettre en œuvre ou non en apportant des justifications. Ces mesures concernent par exemple l’usage responsable du système, la prise en compte de la qualité des données, la sécurité des données, le développement et le cycle de vie du système d’IA. Un organisme qui met en œuvre l’ISO 42001 devra produire in fine une Déclaration d’Applicabilité avec la liste des mesures qu’il applique.

Autre point commun avec la norme ISO 27001, le système de management décrit dans l’ISO 42001 repose sur une analyse des risques lié au fonctionnement et à l’utilisation du système d’IA. Les mesures à mettre en œuvre doivent être priorisées pour traiter les risques avec un niveau de risque trop important. Il est recommandé d’appliquer l’ISO 23894 comme méthodologie d’analyse de risque dans le cadre de l’ISO 42001.

L’ISO 42001 pour se mettre en conformité avec l’AI Act

L’AI Act prévoit l’existence d’un marquage « CE » obligatoire à apposer par les fournisseurs de systèmes d’IA à haut risque sur leurs produits avant leur mise sur le marché ou leur mise en service. Ce signe de reconnaissance indique qu’un système d’IA a été développé, conçu et est maintenu conformément à l’AI Act afin qu’il puisse circuler librement dans le marché intérieur européen. Il est recommandé aux fournisseurs de systèmes d’IA à haut risque de mettre en œuvre un système qualité en adéquation avec l’ISO 42001 afin de préparer au mieux le marquage « CE » de leurs produits.

Le schéma de vérification du marquage « CE » des systèmes d’IA sera similaire aux marquages « CE » existants en lien avec d’autres règlementations européennes et d’autres produits comme les dispositifs médicaux ou les ascenseurs :

- Avant la mise en service de son produit, le fournisseur de système d’IA à haut risque contacte un organisme notifié (en général un organisme de certification) pour faire évaluer sa documentation technique et son système qualité.

- L'organisme notifié procède aux évaluations de la documentation technique et du système qualité du système d'IA. La norme ISO 42001 est pressentie pour être reconnue comme norme harmonisée de l'AI Act et ainsi recommandée comme modèle à suivre pour mettre en oeuvre un système qualité.

- En cas de réussite aux évaluations, le fournisseur appose le marquage « CE » sur son système d’IA à haut risque et peut le distribuer dans l’UE.

Complémentarité et similitudes des normes ISO 42001, ISO 27001 et ISO 27701

ISO 42001

Système de management de l’intelligence artificielle

Norme certifiante

Management par les risques. Méthode d'analyse des risques recommandée : ISO 23894.

Contient une annexe avec des mesures à considérer. Obligation de produire une DDA.

Répond aux enjeux de l’AI Act

ISO 27001

Système de management de la sécurité de l’information

Norme certifiante

Management par les risques. Méthode d'analyse des risques recommandée : ISO 27005, EBIOS RM.

Contient une annexe avec des mesures à considérer. Obligation de produire une DDA.

Répond aux enjeux du RGPD pour la partie sécurité

ISO 27701

Système de management de la protection de la vie privée

Norme certifiante

Management par les risques. Méthode d'analyse des risques recommandée : ISO 27005 ou EBIOS RM couplée avec une Analyse d’Impact sur la Protection des données

Contient une annexe avec des mesures à considérer. Obligation de produire une DDA.

Répond aux enjeux du RGPD au global, d’autant plus si la norme EN 17926 est appliquée en complément

Notre accompagnement

Cyber-Manager, votre partenaire de confiance s’engage continument à vos côtés pour renforcer votre résilience numérique. Nous sommes spécialisés dans l'accompagnement des organisations vers des systèmes de management robustes garantissant la conformité aux normes internationales.

Consciente de l'émergence des technologies utilisant l'intelligence artificielle et des enjeux associés, notre équipe d’experts met à profit son expérience en lien avec la cybersécurité, la protection et la gouvernance des données pour aider les organismes à répondre aux enjeux de l'AI Act.

Nous réalisons également des missions d’audits pour le compte d’organismes de certification (ISO 27001, ISO 27701, HDS, ISO 42001, …), ce qui nous permet d’être à jour du formalisme et des niveaux de sécurité attendus par ces derniers afin de vous orienter dans la bonne direction lors de nos accompagnements.